“Reviven” a celebridades gracias a inteligencia artificial

MOSCÚ.- Investigadores del Centro Samsung de Inteligencia Artificial de Moscú y del Instituto Skolkovo de Ciencia y Tecnología desarrollaron un sistema capaz de transformar imágenes fijas de rostros en secuencias de vídeo con gran realismo.

Con estas, lograron “volver a la vida” a distintas personalidades, así como animar pinturas, explica un artículo del medio El Tiempo.

El algoritmo está inspirado en la tecnología del “deepfake”, un procedimiento diseñado para engañar a las personas haciendo que a partir de una foto se generen videoclips falsos. Incluso, se puede hacer que el sujeto de la imagen hable y ejecute acciones que realmente no ha hecho.

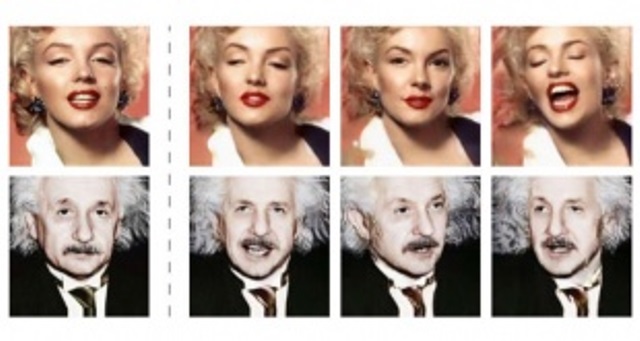

Como lo explica Egor Zakharov, ingeniero desarrollador del sistema, el software consiste en aplicar puntos de referencia de los movimientos de un “rostro objetivo” sobre los de un “rostro fuente”, permitiendo en la práctica que el primero controle la forma en que se mueve el segundo.

La inteligencia artificial de Samsung solo necesita de una a ocho fotos para darle vida al personaje. Con este sistema es posible animar pinturas, como la Mona Lisa, o imágenes de personas que ya han muerto como Marilyn Monroe o Albert Einstein.

“El entrenamiento puede basarse en tan sólo unas pocas imágenes y realizarse de manera rápida pese a la necesidad de ajustar decenas de millones de parámetros”, explicaron los investigadores de Samsung en una publicación científica.

El programa aprende a identificar los factores más característicos de un rostro como los ojos, la forma de la boca y la longitud del puente nasal, y genera expresiones y movimientos. Por último, una red discriminadora se asegura de que el resultado sea fotorrealista.

Según lo afirmó la compañía surcoreana, el modelo generado que funciona como avatar muy similar de una persona, servirá tanto para la industria de los efectos especiales como en el ámbito de la telepresencia (sobre todo en videoconferencias y videojuegos multijugador).

Esta nueva tecnología no deja de llamar la atención por lo peligrosa que puede ser si cae en las manos equivocadas. En el caso del “deepfake” se recrearon videos pornográficos con rostros de personajes públicos, que algunos usuarios publicaron en el sitio web Reddit. Esta técnica, bien podría hacer creer que una celebridad o político hizo declaraciones que realmente no son ciertas.

Publicado originalmente por adndigital.com.py